Il vuoto della legge. Liability Gap e nuove frontiere della responsabilità nell’era dell’AI e della ro(BOT)ica

Giovedì 11 dicembre 2025 si è svolto presso l’Aula Magna Rettorato dell’Università di Torino un confronto tra esperti di AI e di lobbying etico, giuristi, giornalisti manager d’impresa e filosofi. All’incontro, moderato da Ezio Bertino (Ferpi Piemonte e Valle d’Aosta) e Massimo Morelli (Circolo di Filosofia della Mente) e reso possibile dall’impegno dei ragazzi di UniFerpi Piemonte, hanno partecipato Licia Soncini (Nomos), Brando Benifei (eurodeputato e co-estendsore AI Act), Marco Ciurcina (Studiolegale.it), Gaia Contu (Istituto Superiore Sant’Anna di Pisa), Fabio de Ponte (Rai), Riccardo Fava (Ocimp), Marco Gaspardone (TIM Enterprise) e Vincenzo Manfredi (FerpiLab).

Qui pubblichiamo i materiali che sono serviti da inquadramento concettuale del tema.

IL CONCETTO

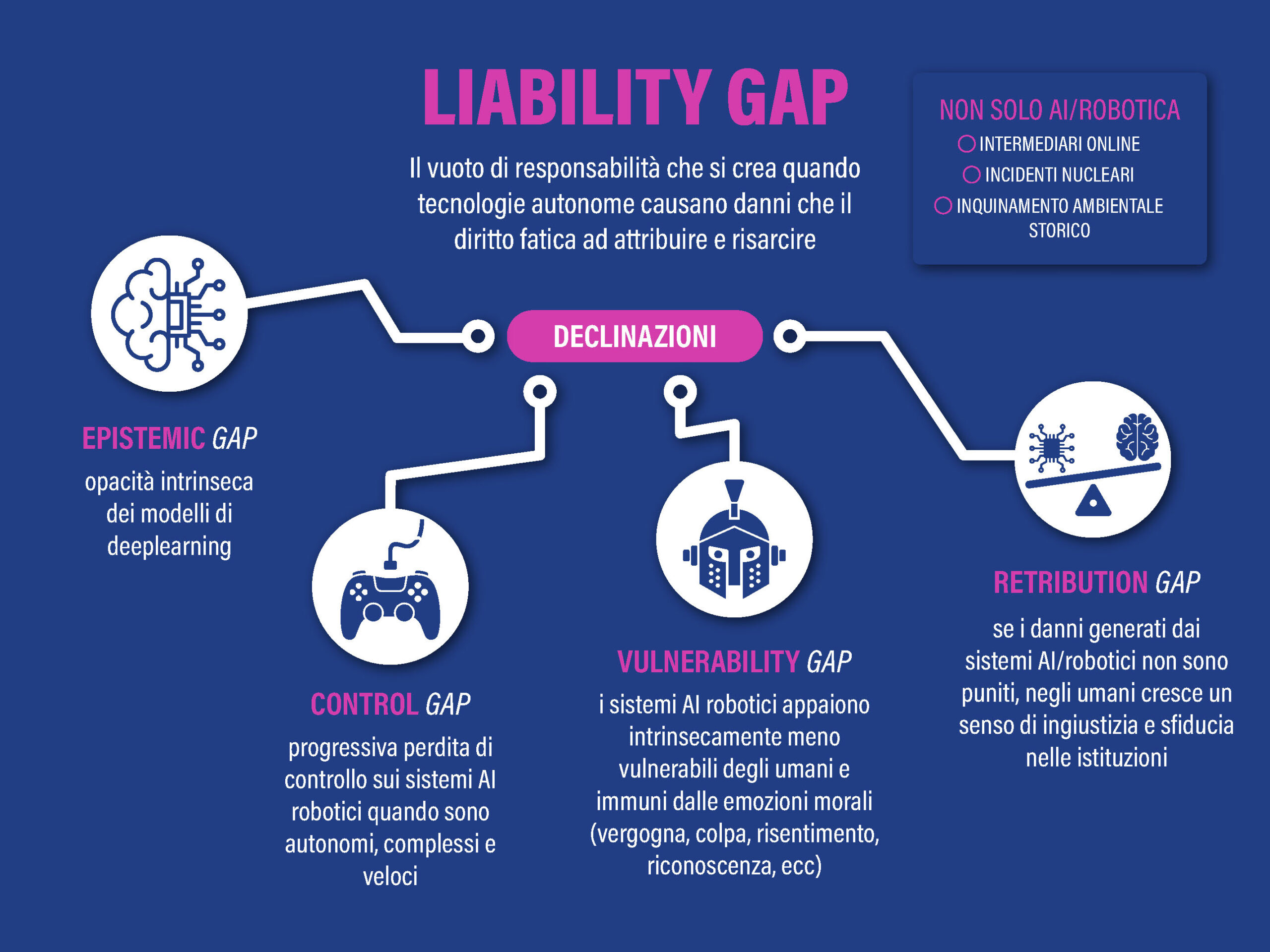

Il concetto di liability gap (o responsibility gap) è uno dei temi centrali nel dibattito giuridico e filosofico sull’AI e la robotica, e rappresenta una delle sfide più complesse per i sistemi normativi contemporanei.

Il liability gap emerge quando sistemi autonomi dotati di capacità di apprendimento sono causa o con-causa di danni, ma non è possibile o giusto attribuire la responsabilità morale o legale né alla macchina stessa (che attualmente non è considerata un agente morale), né agli esseri umani coinvolti (progettisti, operatori, utenti), perché il comportamento pernicioso era imprevedibile e comunque non riconducibile a negligenza umana.

Si verifica la cosiddetta ‘frammentazione della responsabilità’ in quanto a differenza degli strumenti tradizionali sotto controllo umano diretto, i bot autonomi coinvolgono molteplici attori (progettisti, produttori, sviluppatori software, operatori, utenti finali), rendendo difficile identificare il responsabile ultimo e/o unico.

LE SUE DECLINAZIONI

Nello sviluppo del dibattito il concetto di Liability gap si è poi diversificato in una serie di sotto-gap che sottolineano problematiche diverse:

1. Epistemic gap: l’opacità intrinseca dei modelli di deep learning rende impossibile comprendere completamente come giungano a determinate decisioni.

2. Control gap: progressiva perdita della capacità umana di esercitare un controllo significativo e diretto sull’operato di un sistema AI/robotico, specialmente quando il sistema è autonomo, complesso e opera ad alta velocità.

3. Vulnerability gap: mentre gli utenti umani e le parti interessate sono sempre più esposti a potenziali danni causati da sistemi AI/robotici, i sistemi stessi – in quanto artefatti non-senzienti – sono incapaci di reciproco coinvolgimento affettivo e quindi immune dalle conseguenze morali ed emotive delle loro azioni.

Inoltre i sistemi AI/robotici non possono partecipare agli scambi morali caratterizzati da vulnerabilità reciproca – quelli che coinvolgono emozioni morali come vergogna, colpa, risentimento, gratitudine, empatia – che sono fondamentali per la coltivazione dell’agency morale e l’apprendimento morale umano.

4. Retribution gap: si riferisce alla discrepanza tra l’innata disposizione emotiva umana a cercare una punizione (retribuzione) quando si verifica un danno ingiusto e l’assenza di un soggetto morale appropriato su cui riversare tale colpa in un contesto di azioni compiute da sistemi di AI robotici autonomi. Esperti come John Danaher ritengono che alla lunga il retribution gap possa ingenerare un sentimento di sfiducia nelle istituzioni ed eventualmente sommovimenti sociali.

I POSSIBILI FRAME INTERPRETATIVI

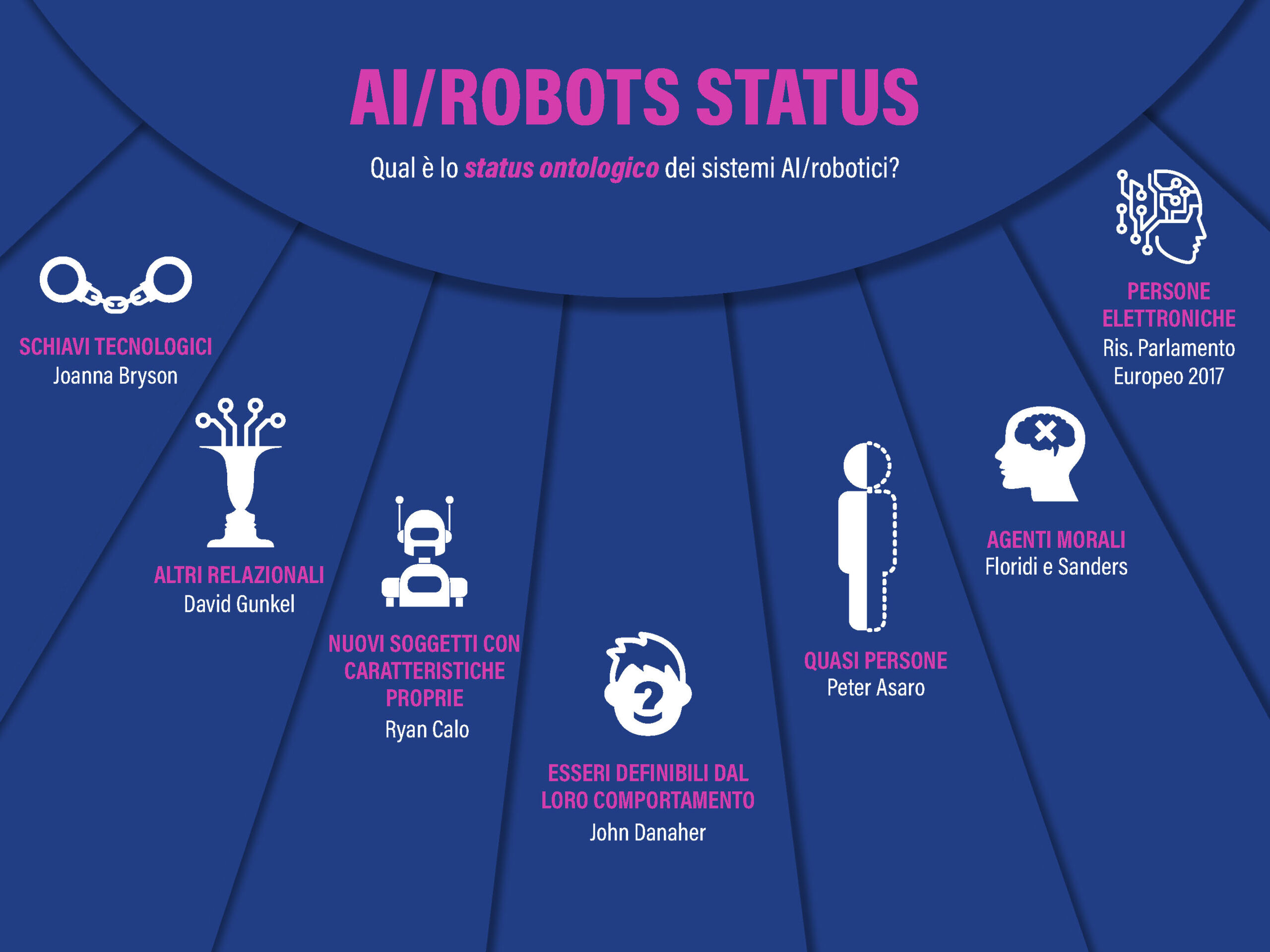

Per generare un quadro normativo confacente, i legislatori si trovano di fronte al problema di definire quale sia lo status ontologico/legale di questi sistemi AI/robotici.

Di fatto nel corso del dibattito i vari protagonisti hanno generato un ventaglio di possibilità che va dall’estremo del considerare i robot dei meri ‘schiavi tecnologici’, a quello opposto che attribuisce loro una personalità giuridica specifica (electronic personhood).

Il ventaglio delle posizioni concettuali emerse nel dibattito è sintetizzabile come segue:

1. RO(BOT) COME SCHIAVI TECNOLOGICI (STRUMENTALISMO PURO)

Joanna Bryson: “robots should be built, marketed and considered legally as slaves” – nel senso che devono rimanere strumenti completamente subordinati agli esseri umani, senza status giuridico autonomo.

2. RO(BOT) COME ‘ALTRI RELAZIONALI’

David Gunkel: dovremmo riconoscere i robot come ‘altri relazionali’ nell’incontro faccia-a-faccia, senza bisogno di determinare prima la loro natura ontologica. Seguendo Levinas, Gunkel suggerisce di vedere i robot non come oggetti da categorizzare ontologicamente, ma come altri con cui entriamo in relazione. Questa relazione stessa genera obblighi etici, indipendentemente da ciò che i robot sono o non sono.

3. RO(BOT) COME NUOVI SOGGETTI

Ryan Calo: dobbiamo identificare le caratteristiche distintive di questi nuovi soggetti tecnologici per comprendere come sfidino i framework normativi esistenti e come il diritto debba adattarsi di conseguenza. Per Calo le caratteristiche distintive sono: corporeità fisica, comportamenti emergenti e rilevanza sociale.

4. RO(BOT) COME ESSERI DEFINIBILI ATTRAVERSO L’OSSERVAZIONE DEL LORO COMPORTAMENTO ETICO

John Danaher: se un sistema AI/robotico si comporta in modo indistinguibile da un’altra creatura o entità a cui normalmente attribuiremmo uno status morale, allora dovremmo attribuire al robot lo stesso status morale (ethical behaviorism). Questo approccio si concentra sul comportamento osservabile piuttosto che su proprietà ontologiche interne.

5. RO(BOT) COME ‘QUASI PERSONE’

Peter Asaro: I robot sono ‘quasi persone’ che potrebbero godere di diritti e doveri ‘parziali’ commisurati al loro status. Dobbiamo creare una sorta di ‘scala mobile’ dello status giuridico, per la quale i robot potrebbero diventare ‘quasi-agenti’ agli occhi della legge prima di raggiungere eventualmente la personalità piena. Questo rispecchia il modo in cui il diritto già tratta entità con responsabilità diminuita (minori, persone con disabilità cognitive, animali domestici).

6. RO(BOT) COME AGENTI MORALI

Floridi e Sanders: per essere un agente morale non è necessario possedere libero arbitrio, emozioni o consapevolezza (concetto di mind-less morality). Per questo, l’agency morale dovrebbe essere allargata per includere non solo esseri umani ma anche animali, corporazioni e sistemi AI/robotici. Tuttavia, per quanto riguarda la personalità giuridica, Floridi sostiene che l’AI potrebbe al massimo ricevere una forma di ‘personalità giuridica derivata’ (derivative legal personhood), non la piena personalità giuridica come gli esseri umani.” L’articolo è del 2004…

LE DUE VISIONI

Il CEO di Deep Mind e Premio Nobel per la Chimica 2024 (pur non essendo un chimico, ma essenzialmente un informatico) Demis Hassabis ha affermato che “abbiamo sempre più indizi che ci portano a ritenere il mondo in cui viviamo ha una natura computazionale, molti aspetti fondamentali della realtà possono essere descritti, previsti e persino sostituiti operativamente da processi di calcolo su informazione, non solo da formule astratte o intuizioni qualitative”.

Dall’altro lato la filosofa della tecnologia Shannon Vallor ritiene che le vecchie meta-narrazioni del passato (escatologia giudeo-cristiana, marxismo-leninismo, etc.) sono state sostituite da un’unica meta-narrazione codice-centrica che lei stessa chiama la ‘Silicon Valley Ideology’: l’essere umano è una macchina auto-replicante che segue programmi codificati, e il robot è il suo successore evolutivo. Non di verità assoluta si tratta, tuttavia, bensì solo di una ideologia, una meta-narrazione.

A quale di queste due visioni alternative ci sentiamo più affini?

INTERROGATIVI GENERALI

1. Il problema del liability gap è un vero problema o in realtà gli ordinamenti giuridici esistenti hanno già gli strumenti idonei a gestire le criticità ingenerate dai sistemi AI/robotici?

2. Siccome ogni possibile inquadramento normativo dei sistemi AI/robotici deriva inevitabilmente dal frame interpretativo che definisce la loro natura, il loro status ontologico, quali dei possibili frame emersi nel dibattito contemporaneo sono da preferirsi in vista di tale obiettivo?

3. Oltre all’aspetto strettamente tecnico-giuridico, il problema del liability gap coinvolge direttamente la politica intesa sia come policy sia come politics. Che posizioni sta assumendo e che posizioni dovrebbe assumere in futuro il mondo della politica in merito a tale questione?

INTERROGATIVI PIÙ TECNICI

1. Se non so perché l’algoritmo ha sbagliato, non posso provare la colpa (il cosiddetto Black-box problem). Molte proposte (come la Direttiva AI Liability dell’UE) tentano di risolvere questo punto con la presunzione di causalità o l’inversione dell’onere della prova. È sufficiente o serve altro?

2. Ha ancora senso applicare il criterio della “colpa” (negligence) a un’entità che non ha intenzioni umane, o bisogna passare a un regime di responsabilità oggettiva (strict liability) simile a quello per i prodotti difettosi? Optare per la responsabilità oggettiva protegge le vittime ma rischia di frenare l’innovazione (chilling effect).

3. Nel processo di creazione di un sistema AI/robotico dotato di capacità di apprendimento sono coinvolti molti diversi soggetti (produttore, sviluppatore, fornitore di dati di training, operatore sul campo, utilizzatore finale, eccetera) e a differenza dei prodotti tradizionali, i sistemi AI evolvono anche dopo la loro commercializzazione. In un tale contesto a che va attribuita la colpa di un eventuale malfunzionamento? È possibile individuare responsabilità individuali o si deve passare a un modello di responsabilità condivisa? (problema della frammentazione delle responsabilità)

4. Se i rischi legati all’attività dei sistemi AI/robotici sono potenzialmente catastrofici, le società assicurative sono in grado di calcolare o coprire questi rischi o serve qualcos’altro, ad esempio un fondo di garanzia statale?

5. Una possibile strategia atta a limitare i rischi legati alle attività dei sistemi AI/robotici è il cosiddetto ‘Human in the loop’, ovvero la presenza di un agente umano che supervisiona l’intero processo decisionale ed esecutivo. Ma così facendo non c’è il rischio di trasformare l’umano coinvolto nel potenziale capro espiatorio cui viene attribuita la responsabilità legale di ogni incidente? (Problema della “moral crumple zone” identificato da M.C. Elish)”